[24’ CVPR] Universal Segmentation at Arbitrary Granularity with Language Instruction

카테고리: Vision

🔍 Abstract

오늘은 CVPR 2024에서 발표된 Universal Segmentation at Arbitrary Granularity with Language Instruction 논문을 리뷰하려고 한다. 이 논문은 Various Granularity 수준에서 모두 적용 가능한 Universal Segmentation을 수행하기 위해 UniLSeg라는 모델을 제안한다. 핵심은 Language Instruction을 통해 granularity 수준을 어떠한 수준으로든 guidance하고, 이를 multiple tasks에 대해 훈련시켜 다양한 수준의 segmentation을 수행할 수 있도록 하는 것이다. 위 그림을 보면 Part Segmentation 수준에서 Scene Segmentation 수준까지 다양한 레벨의 segmentation을 수행할 수 있음을 확인할 수 있다.

1. Introduction

들어가기에 앞서, segmentation의 granularity에 대해 파악할 필요가 있다. 지금까지 다양한 segmentation task가 제시되었는데, 이를 어떤 레벨에서 segmentation할 것인가에 따라 part, instance, group, class, scene 등 다양한 수준에서 segmentation을 수행할 수 있다. 본 논문에서 제시하고 있는 segmentation은 Various Granularity 수준에서 모두 적용 가능한 Universal Segmentation을 수행하는 것이기에, 지금까지 제시된 다양한 segmentation task에 대한 multi-task learning을 수행하고자 한다. 여기서 언급된 segmentation task를 정리해보면 다음과 같다.

- RIS(Referring Image Segmentation)

- SS(Semantic Segmentation)

- SOD(Salient Object Detection)

- PS(Part Segmentation)

- OVS(Open-vocabulary Segmentation)

- RVOS(Referring Video Object Segmentation) (생략)

각각에 대해 자세히 알아보자.

1.1. RIS(Referring Image Segmentation)

RIS(Referring Image Segmentation): Text가 Referring Expression으로 주어지고, 이를 통해 Image Segmentation을 수행하는 task이다.

예를 들면 아래와 같이 이미지와 이미지의 특정 부분을 지칭하는 텍스트가 주어졌을 때, 이 텍스트를 통해 이미지의 특정 부분을 segmentation하는 task이다.

지금까지 계속 언급되는 Baseline model로 CVPR 2022에 소개된 LAVT(Language-Aware Vision Transformer)를 소개한다. 이 모델의 주요 Contribution은 Vision Decoder 부분에만 Language Attention을 주던 기존 모델들과 달리 Vision Encoder에도 Language Attention을 주어 전반적인 Language-Vision Interaction을 강조하였다는 데 있다. Encoder 부분에서부터 Feature Alignment를 진행하겠다는 것이다. 아래 그림의 PWAM(Pixel-Word Attention Module)과 LG(Language Gate)가 그 부분이다. 그리고 일종의 Language-Aware Feature가 Skip-connection을 통해 Vision Decoder로 전달된다는 점도 주목할 만하다.

몇 가지 예시를 보면 다음과 같다.

그리고 Ablation Study를 통해 PWAM과 LG의 중요성을 확인할 수 있다. PWAM은 Language-Aware Feature를 생성해 Decoder로 전달하는 역할을 하며, LG는 Language Feature를 Encoder Feature에 결합하는 역할을 한다. 이를 통해 Encoder 및 Decoder 부분에서 Language Prompt를 인식하는 전 과정의 Language-Vision Interaction이 중요하다는 것을 보였다.

1.2. SS(Semantic Segmentation)

SS(Semantic Segmentation): 이미지의 각 픽셀을 특정 클래스로 분류하는 task이다.

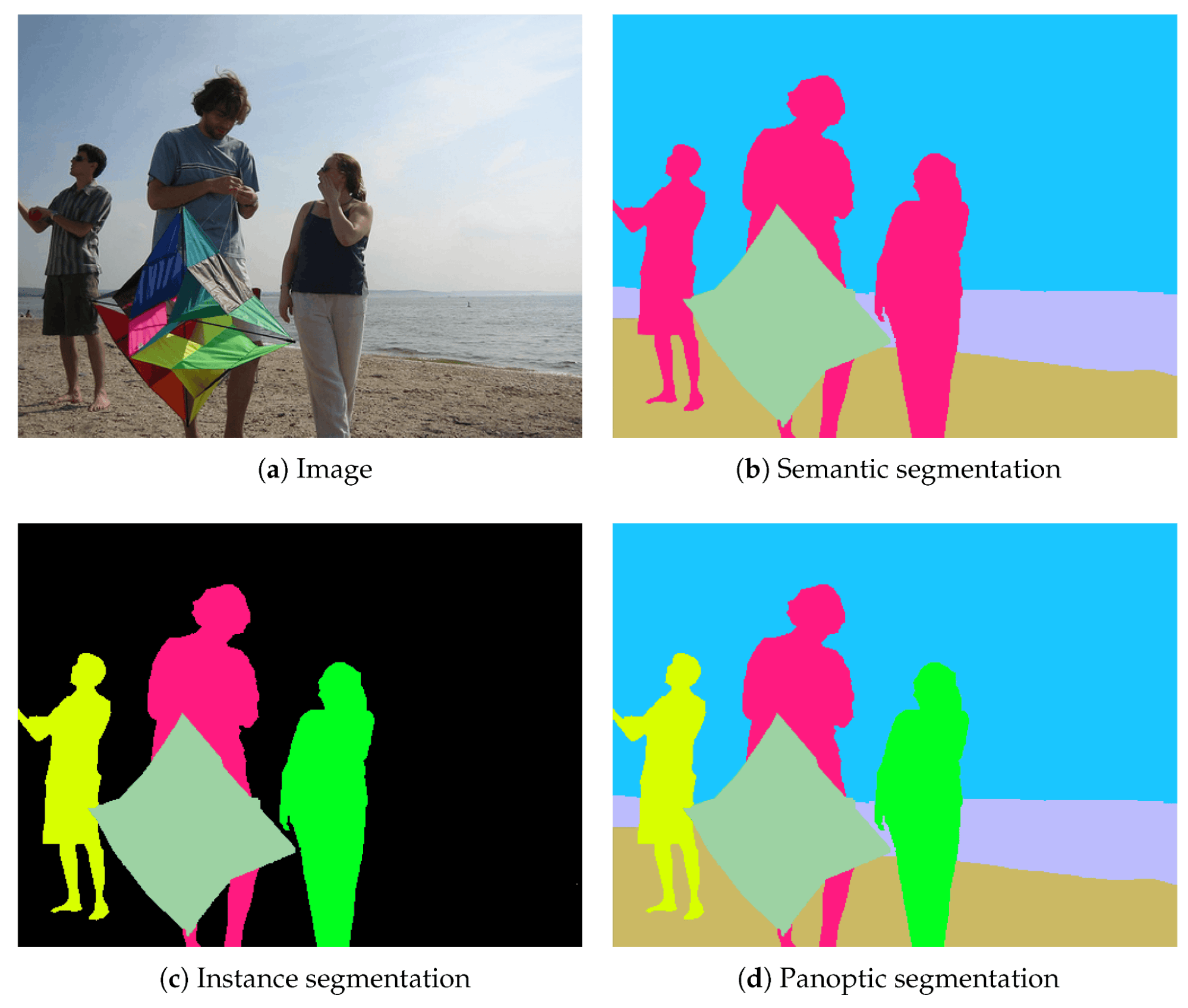

흔히 Semantic Segmentation은 이미지의 의미를 잘 이해하고 각 픽셀에 클래스를 할당하는 것으로 해석할 수 있다. Semantic Segmentation은 Instance Segmentation, Panoptic Segmentation 등 다양한 task로 확장될 수 있으며, 차이점은 아래 사진과 같다.

이 분야에서 가장 유명한 모델 중 하나는 CVPR 2015에서 소개된 FCN(Fully Convolutional Network)일 것이다. 최초로 MLP를 사용하지 않은 모델로 주목을 받았었다. 이 분야에 대해서는 워낙 많은 모델이 소개되었고, 흔히 알려진 task이기 때문에 다른 모델들의 소개는 생략한다.

1.3. SOD(Salient Object Detection)

SOD(Salient Object Detection): 이미지에서 중요한(salient) 객체를 찾아내는 task이다.

Salient Object Detection은 이미지에서 중요한 객체를 찾아내는 task이다. 이미지에서 명확히 구별되는 object를 분리해내는 것이 중요하다. 다양한 scale의 salient region이 존재하기에 이를 상황에 따라 잘 찾아내는 것이 어렵고, 이를 위한 다양한 모델이 소개되었다. 최근에는 해당 task가 다른 task에 포함되는 경우가 많아졌다.

1.4. PS(Part Segmentation)

PS(Part Segmentation): 이미지의 특정 부분을 찾아내는 task이다.

Part Segmentation은 기존 Instance Segmentation보다 더 자세하게 Image Segmentation을 하기 위해 고안된 task이다. ECCV 2022에 소개된 PartImageNet과 같은 데이터셋이 그 예시이다.

1.5. OVS(Open-vocabulary Segmentation)

OVS(Open-vocabulary Segmentation): 이미지에서 텍스트에 해당하는 부분을 찾아내는 task이다. Referring Image Segmentation과 다른 점은, RIS는 임의의 텍스트가 이미지의 특정 부분을 지칭하는 반면 OVS는 텍스트가 분류하고자 하는 카테고리로 제한되어 있다는 점이다. 단, 해당 카테고리는 Open-vocabulary이기 때문에 유저가 제공하는 임의의 카테고리가 될 수 있어야 한다. RIS가 OVS보다 더 고난이도인 task라고 볼 수 있다.

지금까지 Baseline으로 사용되는 모델로 OVSeg가 있다. 해당 모델에서는 CLIP을 사용하여 OVS 문제를 해결하고자 하였는데, Pre-trained CLIP 자체는 masked image에 대한 성능이 좋지 않아 Mask Prompt Tuning이라는 방법을 제안하여 Pre-trained CLIP을 fine-tuning하였다.

이 Mask Prompt Tuning 방식이 참신하여 좋은 평가를 받았다고 생각한다. 기회가 된다면 다음에 한번 다루고자 한다.

2. Method

이제 이들을 어떻게 통합할지 알아보자. 본 논문 이전에 가장 유명한 unified segmentation model은 당연히 SAM(Segment Anything)일 것이다. 이후 수많은 후속 논문들이 등장했고, 이 논문에서는 특히 Language Instruction을 비교적 적극적으로 사용한다는 점이 차별점일 것이다.

2.1. Pipeline

전체 과정을 (1) Encoding Process, (2) Pre-Fusion, (3) Visual-Linguistic Decoding 과정으로 나누어볼 수 있다. 각 과정을 살펴보자.

Encoding Process

Image Encoding과 Text Encoding을 각각 알아보자.

- Image Encoding: Image Encoder는 Swin Transformer를 사용하였다. 이를 통해 Hierarchical feature $f_ v ^ i \in \mathbb{R}^ {H^ i \times W^ i \times C^ i _ v}$를 얻는다. 이때 $i \in \left[ 1, 2, 3, 4 \right]$이다.

- Text Encoding: Text Encoder는 CLIP을 사용하였고, 이를 통해 word embedding $f_w \in \mathbb{R}^ {l \times C_ t}$와 sentence embedding $f_s \in \mathbb{R}^ {1 \times C_ t}$를 얻는다.

Pre-Fusion

이후 Image와 Text를 결합하는 Pre-Fusion 과정을 거친다. 이 과정에서는 Cross-Modal Fusion을 수행하는데, 방식은 일종의 Cross-Attention으로 볼 수 있다.

이를 통해 Activated Visual Feature $f_c$를 얻을 수 있다.

Visual-Linguistic Decoding

각각 Visual Path와 Language Path라는 2개의 Path로 나뉘는데, 이를 통해 Visual-Linguistic Decoding을 수행한다. 이 역시 일종의 Cross-Attention인데, 이때 Pre-Fusion 과정에서 얻은 Activated Visual Feature $f_c$를 사용하기에 Visual Feature, Language Feature가 잘 결합된 Feature를 사용한 Attention이 가능하다. Language Path에서는 이를 통해 일종의 Prompt를 얻는다. Text에 따라 Prompt가 달라지기에, 이를 통해 Various Granularity 수준에서 segmentation을 수행할 수 있다. 일종의 Prompt Learning으로도 볼 수 있다. Visual Path에서는 이를 통해 Text 정보가 포함된 Feature를 얻고, 이후 FPN을 통해 segmentation을 수행한다.

2.2. Task-specific Prompt Design

참고로, 위와 같은 Task-specific Prompt를 사용하여 Multi-task learning이 가능하도록 했다. 이러한 접근은 최근에 많이 사용되는 방법이다.

3. Experiments

3.1. Main Results

전체 결과는 모든 Task에서 SOTA라는 것인데, 이는 Various Granularity 수준에서 segmentation을 수행할 수 있는 UniLSeg의 장점을 보여주는 것이다. Visualization 결과도 다음과 같이 확인할 수 있다.

3.2. Ablation Study

Effectiveness of SA-1B data. SA-1B는 고화질의 많은 데이터를 가지고 있지만, segmentation label이 없기에 SAM 및 BLIP과 같은 모델로 pseudo mask-caption pair를 생성하여 학습시켰다. 이러한 noisy data를 학습시키는 경우, 실제 학습 과정에서 joint training을 수행하기보다는 pre-training을 통해 학습하는 것이 더 효과적이라는 것을 확인할 수 있다.

Effectiveness of Multi-task Joint Training. Multi-task Joint Training 자체는 효과적이지 않다는 것을 알 수 있다. 그러나, Large-scale pseudo-labeled data로 pretraining 후 훈련하는 경우에는 multi-task joint training이 효과적이다.

💡 Summary

UniLSeg 논문은 arbitrary semantic level segmentation을 language instruction을 통해 수행하는 방법을 제안한다. 본 논문은 구조상에서 다른 구조에 비해 Language Instruction을 Image에 적극적으로 Alignment를 수행하도록 하여 Text의 중요성을 강조했다. 이러한 Universal Segmentation Model 연구가 최근 활발하게 이루어지고 있기에, Natural Image에 대한 Arbitrary Segmentation이 가능해질 것으로 기대된다.

📃 Reference

- [24’ CVPR] Universal Segmentation at Arbitrary Granularity with Language Instruction

- [22’ CVPR] LAVT: Language-Aware Vision Transformer for Referring Image Segmentation

- [23’ CVPR] Open-Vocabulary Semantic Segmentation with Mask-adapted CLIP

댓글 남기기